2023年中国智算中心技术架构分析 AI芯片、AI服务器、AI集群以及AI大模型为关键技术【组图】

智算中心行业主要上市公司:浪潮信息(000977.SZ);中科曙光(603019.SH);商汤-W(00020.HK);光环新网(300383.SZ);科华数据(002335.SZ);奥飞数据(300738.SZ)等

本文核心指标:中国AI服务器市场规模;生成式AI训练大模型汇总

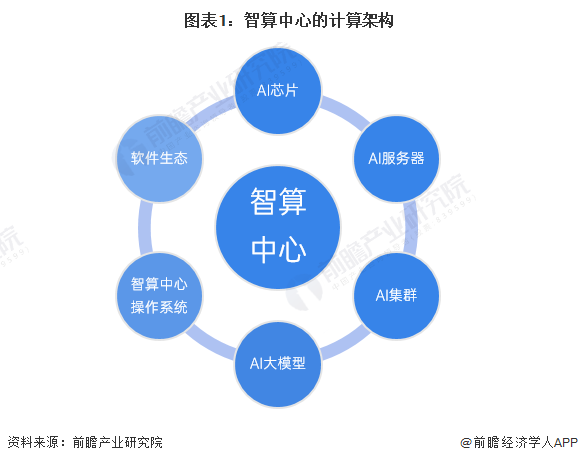

智算中心采用领先的人工智能计算架构

《智能计算中心创新发展指南》指出,智算中心的发展基于最新人工智能理论和领先的人工智能计算架构,算力技术与算法模型是其中的关键核心技术,算力技术以AI芯片、AI服务器、AI集群为载体,而当前的算法模型发展趋势以AI大模型为代表。在此基础上,通过智算中心操作系统作为智算中心的“神经中枢”对算力资源池进行高效管理和智能调度,使智算中心更好地对外提供算力、数据和算法等服务,支撑各类智慧应用场景落地。而软件生态则是智算中心“好用、用好”的关键支撑。

AI芯片是智能计算的主流模式

基于AI芯片的加速计算是当前智能计算的主流模式。AI芯片通过和AI算法的协同设计来满足AI计算对算力的超高需求。当前主流的AI加速计算主要是采用CPU系统搭载GPU、FPGA、ASIC等异构加速芯片。

近年来,国产AI加速芯片厂商持续发力,在该领域取得了快速进展,相关产品陆续发布,覆盖了AI推理和AI训练需求,其中既有基于通用GPU架构的芯片,也有基于ASIC架构的芯片,另外也出现了类脑架构芯片,总体上呈现出多元化的发展趋势。

AI服务器是智算中心建设中最关键的设备

根据《智能计算中心创新发展指南》,AI服务器是智算中心建设中投入比重最大、最为关键的设备。AI服务器是智算中心的算力机组。当前AI服务器主要采用CPU+AI加速芯片的异构架构,通过集成多颗AI加速芯片实现超高计算性能。目前业界以NVLink和OAM两种高速互联架构为主,其中NVLink是NVIDIA开发并推出的一种私有通信协议,其采用点对点结构、串列传输,可以达到数百GB/s的P2P互联带宽,极大地提升了模型并行训练的效率和性能。

根据IDC发布的《中国半年度加速计算市场(2022下半年)跟踪》报告,2022年中国AI服务器市场规模达到67亿美元,同比增长24%。其中GPU服务器依然是主导地位,占据89%的市场份额,达到60亿美元。同时NPU、ASIC和FPGA等非GPU加速服务器以同比12%的增速占有了11%的市场份额,达到7亿美元。

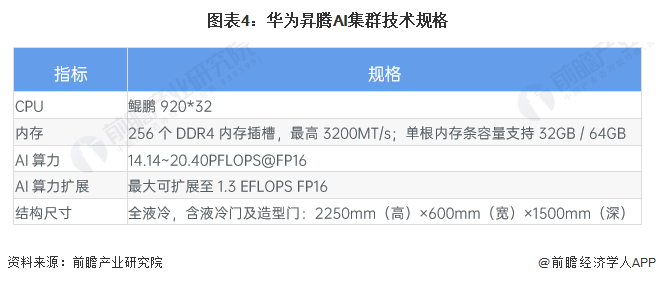

AI集群能够满足智算中心的大规模算力需求

大模型参数量和训练数据复杂性快速增长,对智算系统提出大规模算力扩展需求。通过充分考虑大模型分布式训练对于计算、网络和存储的需求特点,可以设计构建高性能可扩展、高速互联、存算平衡的AI集群来满足尖端的智能计算需求。

2023年7月,华为宣布昇腾AI集群全面升级,推出首个万卡AI集群,拥有更快的训练速度和30天以上的稳定训练周期,十倍领先业界。目前,昇腾AI集群已支撑全国25个城市的人工智能计算中心建设,其中7个城市公共算力平台入选首批国家“新一代人工智能公共算力开放创新平台”。

AI大模型是一种新的智能计算范式

超大规模智能模型,简称大模型,是近年兴起的一种新的人工智能计算范式。和传统AI模型相比,大模型的训练使用了更多的数据,具有更好的泛化性,可以应用到更广泛的下游任务中。按照应用场景划分,AI大模型主要包括语言大模型、视觉大模型和多模态大模型等。业界典型的自然语言大模型有GPT-3、源、悟道和文心等。视觉大模型也已广泛应用于自动驾驶、智能安防、医学影像等领域。基于多模态大模型的以文生图技术也迅速发展,AI内容生成(AI Generated Content,AIGC)已成为下一个AI发展的重点领域。

更多本行业研究分析详见前瞻产业研究院《中国智算中心行业发展前景预测与投资战略规划分析报告》。

同时前瞻产业研究院还提供产业大数据、产业研究报告、产业规划、园区规划、产业招商、产业图谱、智慧招商系统、行业地位证明、IPO咨询/募投可研、专精特新小巨人申报、十五五规划等解决方案。如需转载引用本篇文章内容,请注明资料来源(前瞻产业研究院)。

更多深度行业分析尽在【前瞻经济学人APP】,还可以与500+经济学家/资深行业研究员交流互动。

前瞻产业研究院 - 深度报告 REPORTS

本报告前瞻性、适时性地对智算中心行业的发展背景、供需情况、市场规模、竞争格局等行业现状进行分析,并结合多年来智算中心行业发展轨迹及实践经验,对智算中心行业未来...

如在招股说明书、公司年度报告中引用本篇文章数据,请联系前瞻产业研究院,联系电话:400-068-7188。

品牌、内容合作请点这里:寻求合作 ››

前瞻经济学人

专注于中国各行业市场分析、未来发展趋势等。扫一扫立即关注。