2024年全球大语言模型道德伦理风险分析及应对措施 正确认识大语言模型发展的两面性【组图】

行业主要上市公司:百川智能(A04400.SH)、昆仑万维(300418.SZ)、拓维信息(002261.SZ)、浪潮信息(000977.SZ)、科大讯飞(002230.SZ)等

本文核心数据:针对大语言模型歧视、负面言论的解决方案;大语言模型在信息泄露领域的危害和缓解策略等

引言

大语言模型的迅猛发展为人工智能领域带来了革命性的进步,它们在自然语言理解、文本生成、机器翻译等方面展现出巨大的潜力和广泛的应用前景。这些模型能够提供个性化的用户体验,辅助决策制定,甚至在内容创作和教育等领域释放人类的创造力。然而,这种技术进步的同时也带来了双面性。一方面,大语言模型依赖于大量的数据进行训练,这可能涉及隐私泄露和数据安全问题;另一方面,模型可能会无意中学习并传播偏见和不当内容,对社会价值和伦理道德造成冲击。

风险一:歧视、负面言论

人工智能系统的训练依赖于大量的数据集,而这些数据集往往来源于现实世界,可能带有社会中存在的不平等现象和偏见。这可能导致大语言模型在处理信息时反映出不公正的社会观念,甚至可能边缘化弱势群体或煽动仇恨和暴力。例如,数据集中可能存在的偏见,如基于种族或社会经济地位的歧视,可能通过大语言模型的“技术中立”外衣被无意中强化和固化。为缓解这一问题,可采取的措施包括提升数据集的多样性和包容性、加入偏见检测与纠正机制、模型微调等,具体如下表所示:

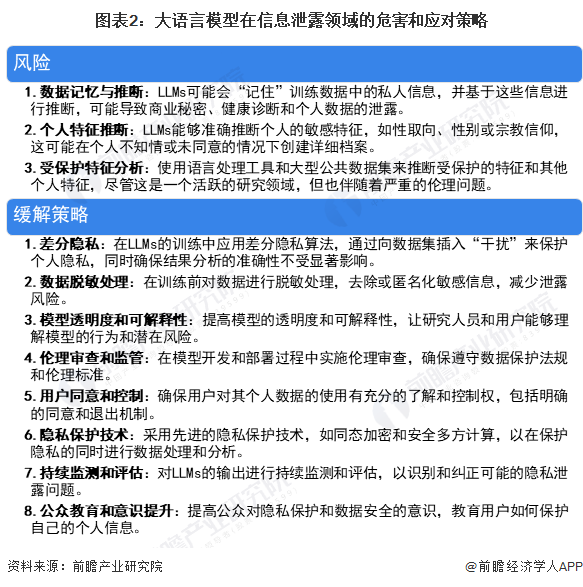

风险二:信息泄露的危害

大型语言模型(LLMs)在处理和生成信息时可能会无意中泄露私人或敏感信息,这引发了对隐私保护和数据安全的严重关切。以下是一些可能的风险和相应的缓解策略:

风险三:虚假信息危害

大型语言模型(LLMs)在信息处理和输出方面存在的风险,以及由此产生的危害,是当前人工智能领域亟需解决的问题。以下总结了LLMs可能带来的风险和相应的缓解策略:

风险四:恶意使用的风险

恶意使用大型语言模型(LLMs)的风险随着技术的普及而增加,这些风险包括但不限于制造虚假信息、威胁网络安全、提高犯罪效率等。以下是一些潜在的恶意使用风险和相应的应对措施:

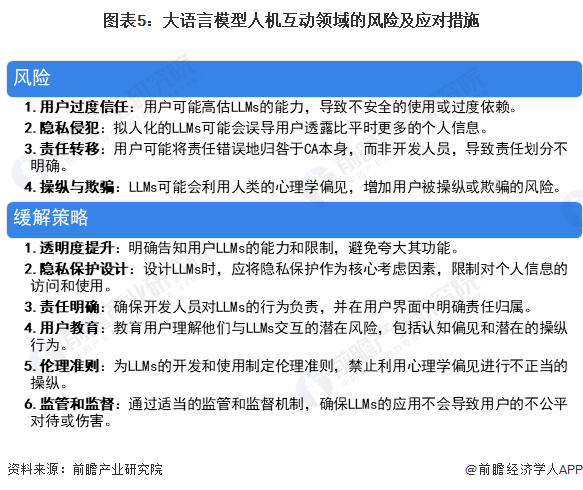

风险五:人机互动的危害

大型语言模型(LLMs)通过学习其训练语料库中的统计属性来生成语言,这些语料库通常来自网页、书籍或其他文本资源。LLMs生成的文本不是直接输出,而是通过概率分布抽样得到的。这种生成方式使得LLMs可以用于各种应用,包括对话代理(CAs),如聊天机器人、教育助手和陪伴工具等。然而,LLMs在人机交互中的使用也带来了一些特殊的风险:

更多本行业研究分析详见前瞻产业研究院《中国大模型产业发展前景与投资战略规划分析报告》。

同时前瞻产业研究院还提供产业大数据、产业研究报告、产业规划、园区规划、产业招商、产业图谱、智慧招商系统、行业地位证明、IPO咨询/募投可研、专精特新小巨人申报、十五五规划等解决方案。如需转载引用本篇文章内容,请注明资料来源(前瞻产业研究院)。

更多深度行业分析尽在【前瞻经济学人APP】,还可以与500+经济学家/资深行业研究员交流互动。更多企业数据、企业资讯、企业发展情况尽在【企查猫APP】,性价比最高功能最全的企业查询平台。

前瞻产业研究院 - 深度报告 REPORTS

本报告前瞻性、适时性地对大模型产业的发展背景、供需情况、市场规模、竞争格局等行业现状进行分析,并结合多年来大模型产业发展轨迹及实践经验,对大模型产业未来的发展...

如在招股说明书、公司年度报告中引用本篇文章数据,请联系前瞻产业研究院,联系电话:400-068-7188。

品牌、内容合作请点这里:寻求合作 ››

前瞻经济学人

专注于中国各行业市场分析、未来发展趋势等。扫一扫立即关注。